Skąd biorą się problemy z indeksacją? Jak przyspieszyć indeksowanie stron w Google? Aby odpowiedzieć sobie na te pytania, należy zrozumieć, na czym polega indeksowanie stron www, co ma na to wpływ i co zrobić, żeby roboty Google były częstymi gośćmi w naszej witrynie.

Czym jest indeksowanie stron i jaki mamy na nie wpływ?

Według definicji indeksacja stron w Google to proces, w ramach którego jego roboty, określane jako boty indeksujące lub crawlery, przeszukują i analizują treści zawarte na stronach internetowych. Ich głównym celem jest jak najlepsze zrozumienie struktury oraz zawartości danej witryny, aby móc później skutecznie odpowiadać na oczekiwania użytkowników i wyświetlać takie serwisy, które najlepiej pasują do zapytań z wyszukiwarki.

Ważne zatem jest, aby Twoja strona internetowa zawierała jak najwięcej treści, dzięki którym będzie można ją znaleźć w sieci. Musisz zadbać o to, aby witryna spełniała wymagania Google pod względem technicznym, jak również o to, by boty trafiały do serwisu z różnych miejsc w internecie.

Masz dwa kierunki działań związanych z tym, co dzieje się na samej stronie i poza nią. Wewnętrzne metody obejmują przede wszystkim odpowiednią optymalizację techniczną serwisu, a także ilość i jakość contentu. Zewnętrzne opierają się głównie na pozyskiwaniu odnośników do Twojej witryny. Twoim zadaniem jako właściciela strony jest zajęcie się każdym z tych aspektów.

Indeksowanie a pozycjonowanie – jak te czynniki na siebie oddziałują?

Wiesz już, że indeksowanie to proces, w trakcie którego boty Google przeszukują cyberprzestrzeń i gromadzą informacje, które uznają za wartościowe na tyle, by przekazać je dalej.

Kiedy tworzysz stronę internetową, chcesz, żeby dotarła do jak największej liczby odbiorców. W tym celu warto opracować strategię marketingową uwzględniającą działania SEO. Pozycjonowanie, bo o nim mowa, to taki sposób optymalizacji strony, aby dopasować ją do algorytmów wyszukiwarki internetowej, tym samym zwiększając jej widoczność w wynikach wyszukiwania.

Co więc łączy pozycjonowanie i indeksowanie witryny?

Przede wszystkim strony niezaindeksowanej nie da się pozycjonować, ponieważ w ogóle nie będzie się ona pojawiać w wynikach wyszukiwania. Co więcej, podstrony zoptymalizowane pod SEO mają większe szanse na sprawną i szybką indeksację. Jeśli roboty odpowiednio zrozumieją dostarczane przez Ciebie treści, będą w stanie je odpowiednio zaklasyfikować, a to z kolei pozwoli na pojawianie się witryny na lepszych pozycjach w wyszukiwarce na wybrane frazy. Dlatego indeksowanie i pozycjonowanie są ściśle ze sobą związane, a ich skuteczność wpływa na efektywną obecność naszej marki online.

Przy nowo powstałych stronach dobrze jest zająć się najpierw działaniami związanymi z ich optymalizacją. Staranie się o indeksację przed naniesieniem odpowiednich zmian na stronie może doprowadzić do tego, że Google zaindeksuje roboczą wersję witryny, niezgodną z wytycznymi SEO. Dlatego najpierw musisz upewnić się, że serwis nie potrzebuje poprawek, a dopiero później skupić się na aspekcie indeksacji.

Inaczej sprawa wygląda w przypadku istniejących już od jakiegoś czasu serwisów. Tutaj warto wykorzystać dane uzyskane w procesie wcześniejszych indeksacji (do sprawdzenia m.in. w Google Search Console). Dla przykładu, jeśli boty Google zaindeksowały Twoją stronę pod frazami, których nie brałeś(-aś) wcześniej pod uwagę, a mają one pozytywny wpływ na Twój biznes, rozważ zoptymalizowanie contentu na stronie tak, aby odpowiadał tym słowom kluczowym. Może to się przełożyć na poprawę pozycji w Google.

Jak działa indeksowanie w wyszukiwarce Google? Omówienie procesu

Aby Google boty mogły odnaleźć jakąś stronę w sieci, muszą przejść dość długą drogę. Dla uproszczenia ścieżkę tę opisuje się w 4 krokach, które pojedynczy robot musi wykonać, aby zaindeksować stronę i potem zaprezentować ją w wynikach wyszukiwania.

Pierwszy krok to crawlowanie. Crawler wędruje po linkach od strony do strony w poszukiwaniu nowych treści.

Drugi krok nazywamy renderowaniem. Następuje w momencie, kiedy crawler już trafi na stronę. Zaczyna zbierać wszystkie dane: treści, meta opisy, grafiki itd. Analizuje to wszystko i przetwarza tak, aby prawidłowo zrozumieć stronę.

Trzeci etap to indeksowanie – crawler przekazuje zdobyte dane do algorytmów indeksujących. Informuje, o czym jest dana witryna, a algorytmy porządkują wszystkie otrzymane wiadomości, aby później stworzyć z nich indeks.

Czwarty krok to rankingowanie. Stworzony przez algorytmy spis treści witryny jest przechowywany w bazie danych. Ma to ułatwiać im w przyszłości szybkie odnalezienie informacji, które wykorzystają, aby odpowiedzieć na zapytanie internautów, przedstawiając w wynikach wyszukiwania odpowiednio dopasowane strony internetowe.

Na prawidłowy przebieg całego procesu zasadniczy wpływ ma to, czy boty Google właściwie zrozumiały zawartość witryny. Dlatego niesamowicie ważna jest optymalizacja strony pod kątem SEO.

Jak sprawdzić, czy Google zaindeksowało stronę?

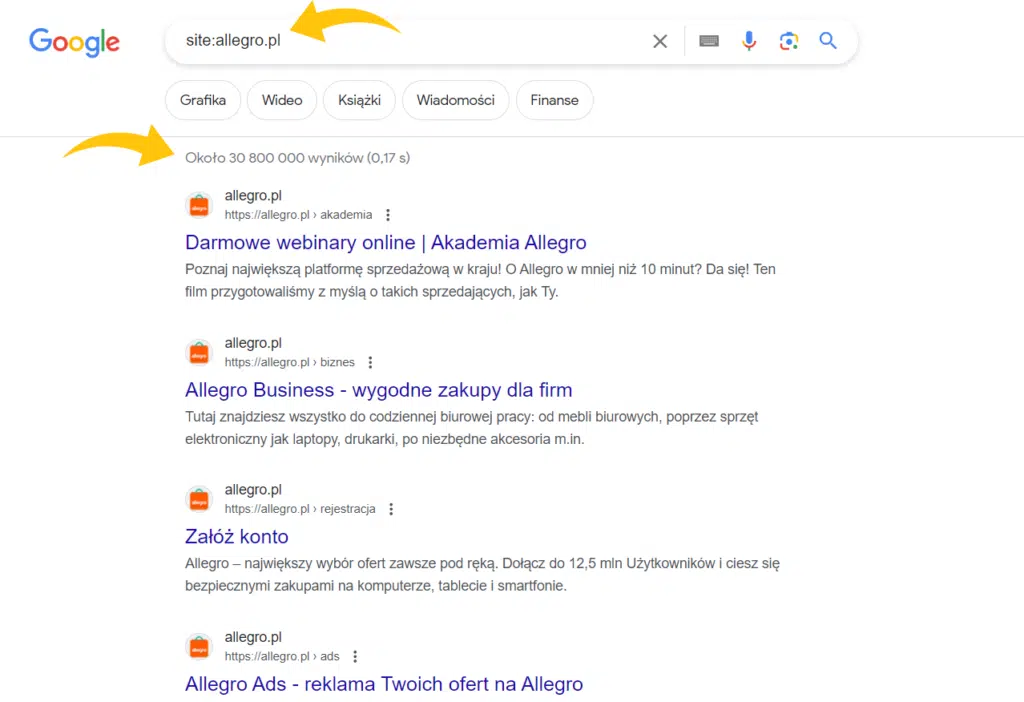

Najprostszym i najszybszym sposobem na sprawdzenie statusu indeksacji jest wpisanie komendy „site:” przed adresem strony.

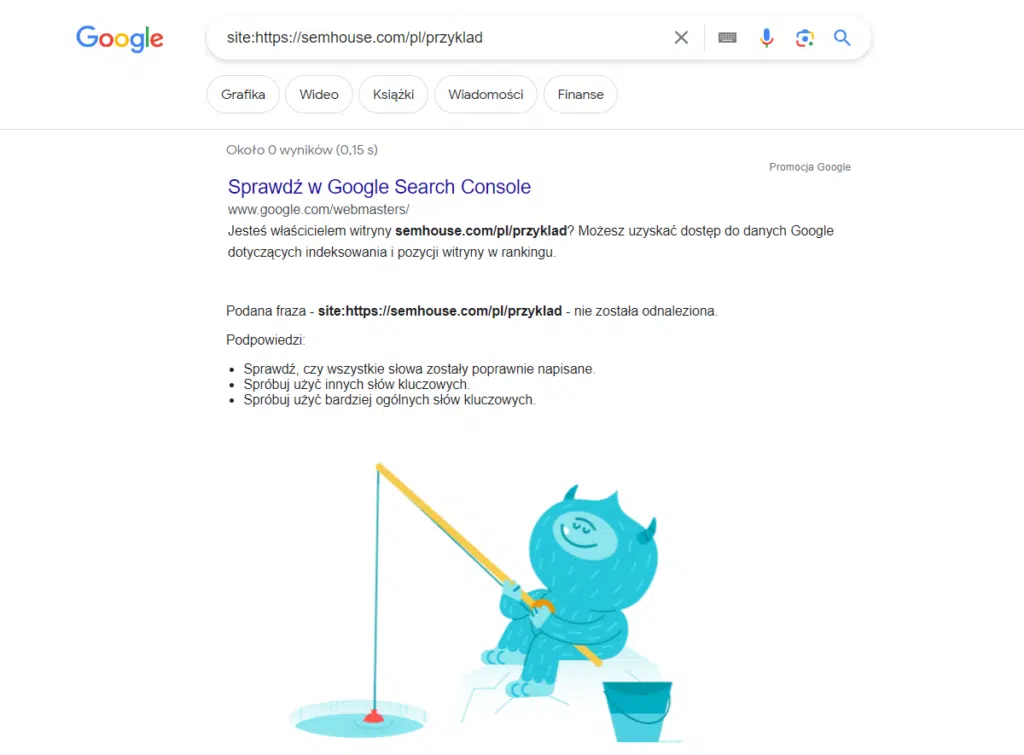

Wykorzystanie tego operatora pozwoli Ci poznać liczbę zaindeksowanych podstron w Twojej domenie. W wynikach otrzymasz wszystkie linki prowadzące do miejsc, które roboty już przecrawlowały. Możesz też sprawdzić status indeksacji konkretnej podstrony, wpisując w okienko wyszukiwarki jej bezpośredni adres. Jeśli natomiast zamiast wyników pojawi się taki obrazek:

oznacza to, że sprawdzana przez Ciebie strona nie jest jeszcze zaindeksowana przez Google lub jej adres został błędnie zapisany, jak ten stworzony przez mnie dla przykładu.

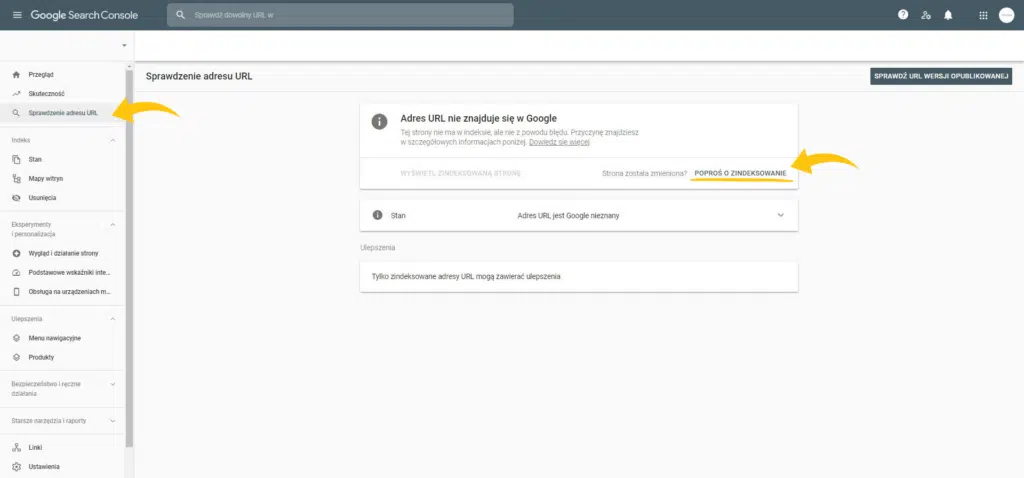

Jak sprawdzić indeksowanie strony w inny sposób? Możesz wykorzystać do tego Google Search Console (GSC). Dzięki temu narzędziu nie tylko sprawdzisz, czy dany URL znajduje się w zasobach Google, ale także zgłosisz stronę do indeksacji.

Najczęściej popełniane błędy, które sprawiają, że roboty crawlujące nie mogą nas znaleźć

Jeśli regularnie dodajesz treści na swoją stronę i dbasz o linkowanie zewnętrzne, a mimo to podstrony nie są indeksowane, warto przeprowadzić analizę techniczną serwisu. Pomoże Ci ona w ustaleniu, czy kondycja strony spełnia kryteria algorytmów indeksujących.

Zadbaj koniecznie o protokół Hypertext Transfer Protocol Secure (https). Jest to szyfrowanie informacji przesyłanych między naszą domeną a klientem. To bardzo ważny aspekt bezpieczeństwa i jedno z wymagań stawianych witrynom przez Google.

Warto przyjrzeć się szybkości ładowania się strony na urządzeniach mobilnych oraz desktopach. Żyjemy obecnie w ciągłym pośpiechu i tak samo zależy nam, aby interesująca nas witryna otwierała się natychmiast po kliknięciu w jej adres, zwłaszcza podczas korzystania ze smartfonów. Jeśli musimy czekać dłużej niż 5 sekund, zwykle się zniechęcamy i poszukujemy alternatywy, czyli takiej strony, która od razu się ładuje. Podobnie działa robot Google. Jeśli Twoja strona jest za wolna, nie będzie chciał jej dodatkowo obciążać swoją wizytą, przez co stracisz szansę na indeksację. Wyeliminuj zasoby blokujące renderowanie, a Twoja witryna będzie chętniej odwiedzana przez Googleboty.

Niska jakość treści jest jednym z głównych czynników wpływających na brak zainteresowania crawlerów daną stroną. Thin content, czyli treści słabej jakości, z błędami, powielone w wielu miejscach na stronie, a także zbyt krótkie nie są przez Google postrzegane jako istotne, więc boty w ogóle nie tracą czasu na to, żeby je indeksować. Trzeba pamiętać, że w dobie sztucznej inteligencji jakościowy i merytoryczny content stanowi jeszcze większą wartość niż przed pojawieniem się AI. Dlatego zadbaj o to, aby Twoja domena zawierała teksty odpowiedniej długości, unikalne opisy kategorii i produktów, a także prawidłowe meta tagi.

Jeśli wszystkie powyższe błędy zostały wyeliminowane, a witryna wciąż nie jest widoczna dla Google, sprawdź, jak wygląda plik robots.txt. Jest to zbiór instrukcji dla wszystkich robotów crawlujących, zawierający informacje na temat tego, co wolno im indeksować, a czego nie. Dlatego konieczne jest stworzenie odpowiednio sprecyzowanych wytycznych dla tego pliku.

Inny dość popularny problem może się pojawić przy zmianie adresu strony. Jeśli nie zostanie ona poprawnie przeniesiona, część adresów w obrębie domeny może zwracać błąd 404 (not found) który utrudni odnalezienie Twojej strony. Zadbaj o odpowiednie przekierowania i linki kanoniczne, aby Twój nowy adres był łatwo dostępny dla robotów crawlujących.

Indeksowanie stron w Google – jak przyśpieszyć ten proces?

Czas oczekiwania na zaindeksowanie strony przez Google bywa różny. Może wynosić kilka sekund, jak i kilka tygodni. To dlatego, że indeksacja odbywa się cyklicznie i jest uzależniona od aktualizacji algorytmów. Możesz więc cierpliwie czekać, aż boty dotrą do Twojej strony w swoim czasie, albo spróbować je zachęcić do odwiedzin. W tym celu warto zastosować kilka skutecznych praktyk.

Przede wszystkim korzystaj z Google Search Console – indeksowanie domeny możesz tam na bieżąco monitorować, a w razie potrzeby także wymusić. W tym celu wybierz funkcję „Sprawdzenie adresu URL” i jeśli strona nie została jeszcze zaindeksowana, kliknij „Poproś o zindeksowanie”.

Kolejnym sposobem na zwiększenie szans na indeksację jest stworzenie czytelnej mapy strony i jej regularne aktualizowanie.

Twórcy Google zachęcają również do korzystania z narzędzia Indexing API. Umożliwia ono aktywne powiadamianie botów o nowych lub zmienionych treściach na stronie w czasie rzeczywistym. Dzięki temu Google szybciej zarejestruje wprowadzone modyfikacje, co może okazać się kluczowe zwłaszcza w przypadku treści dynamicznych .

Porady, jak szybciej zaindeksować stronę w Google – lista kontrolna

Na to, jak przyspieszyć indeksację strony w Google, ma wpływ wiele czynników. Zapoznaj się z checklistą zawierającą kolejne działania, jakie warto wykonać, żeby Twoja strona była widoczna w Google.

Elementy wpływające na indeksowanie strony w Google

- Roboty Google chcą dawać użytkownikom wyszukiwarki jak najlepsze odpowiedzi na ich zapytania, dlatego bardzo ważne jest, aby zadbać o regularne dostarczanie jakościowych i unikalnych treści w obrębie Twojej domeny. Dzięki temu nauczysz algorytmy, że na Twojej stronie systematycznie pojawiają się nowe informacje. Warto również pamiętać o aktualizowaniu starszych artykułów.

- Sitemap XML to istotne miejsce w Twoim serwisie, ponieważ zawiera listę wszystkich stron w witrynie. Możesz ją dodać w narzędziu GSC. Dzięki aktualnej sitemapie Googleboty będą się lepiej orientować w budowie Twojej strony i szybciej zauważą zmiany w jej obrębie.

- Odpowiednio wdrożone linkowanie wewnętrzne sprawnie poprowadzi boty przez wszystkie podstrony i pomoże im zrozumieć strukturę całej domeny. Stosowanie prawidłowo dobranych anchor tekstów i ich naturalne wplatanie w treści będzie miało pozytywny wpływ na indeksowanie stron.

- Responsywność strony to coś, co znacząco wpływa na odwiedziny robotów. Zadbaj o to, aby czas ładowania strony na urządzeniach mobilnych i stacjonarnych nie przekraczał 5 sekund.

Czytelna mapa strony a skanowanie (crawling)

- Zadbaj o to, aby linkowanie wewnętrzne na stronie układało się w logiczną całość. Stosuj ścieżki nawigacyjne w celu ułatwienia botom zrozumienia struktury serwisu.

- Zadbana mapa strony będzie informowała o ważnych miejscach w witrynie. Warto monitorować sitemapę w narzędziu Google Search Console, aby mieć pewność, że dostarcza ona robotom aktualne dane.

- Dyrektywy w pliku robots.txt są niezwykle ważne dla „porozumienia się” z robotami Google. Prawidłowo skonfigurowany plik będzie je informował, co powinny zaindeksować, a co ominąć (disallow).

- Dyrektywa crawl-delay jest świetnym rozwiązaniem, jeśli Twój serwer bywa przeciążony. Pamiętaj, że nie tylko boty Google odwiedzają strony internetowe. Robią to także np. roboty licznych narzędzi SEO, badające różne dane. Spotkanie się w serwisie dwóch lub więcej crawlerów może znacznie spowolnić działąnie Twojej strony. Dlatego warto skorzystać z zapisu crawl-delay, aby opóźnić indeksowanie poszczególnych stron, unikając tym samym nadmiernego obciążenia serwerów.

- Tagi kanoniczne informują boty, która ze stron zawierających duplicate content jest „oryginałem”, a zatem powinna zostać zaindeksowana. Google nie marnuje czasu na indeksowanie nieoryginalnych treści, a Ty unikasz ryzyka kary.

Narzędzia SEO kontrolujące indeksowanie strony w Google

- Google Search Console – w artykule wielokrotnie pojawiła się już informacja o korzyściach płynących z tego narzędzia. Umożliwia ono badanie kondycji domeny i pozwala na szybsze zaindeksowanie stron, a do tego jest całkowicie darmowe.

- Pliki robot.txt również były tu często wspominane. Możemy dzięki nim zarządzać tym, co chcemy pokazać wyszukiwarce Google. Domyślnie kod strony ma wartość „index, follow”, czyli pozwalającą na pełną ekspozycję. Możemy zmienić ją na „noindex, nofollow” mówiącą, żeby nie indeksować i w ogóle nie śledzić strony. Jest to przydatne np. w momencie, kiedy wciąż jeszcze pracujemy nad stroną i nie chcemy, żeby Google za szybko ją zaindeksowało. Mamy jeszcze opcję „noindex, follow” umożliwiającą odwiedziny strony bez jej indeksacji oraz „index, nofollow”, zgodnie z którą strona powinna zostać zaindeksowana, ale bez uwzględniania jej w wynikach wyszukiwania.

- Indexing API to narzędzie stworzone na potrzeby indeksacji podstron w jak najkrótszym czasie. Na bieżąco informuje roboty Googla o nowych treściach, wpływając w ten sposób na szybsze crawlowanie strony.

Crawl budget – optymalizuj stronę pod kątem budżetu crawlowania

Każdy z wyżej wymienionych elementów tworzy podstawy do opracowania strategii umożliwiającej szybsze indeksowanie witryny. Istotną kwestią jest zrozumienie, jak przebiega indeksowanie Google. Roboty muszą poświęcić olbrzymią ilość mocy obliczeniowej, aby odwiedzić wszystkie strony internetowe. A ponieważ muszą w jakiś sposób ocenić, gdzie opłaca im się zajrzeć, a gdzie nie, Google stworzyło pewne zasady indeksowania stron w internecie.

Crawl budget to stworzone przez Google ograniczenia w zasobach, jakie wyszukiwarka przydziela na indeksowanie lub przeglądanie zawartości danej witryny. Podczas jednej wizyty na stronie roboty Google muszą sprawdzić strukturę strony, przeanalizować nowe treści, jak również sprawdzić, czy stare się nie zmieniły i są wciąż w tych samych miejscach, które wcześniej zostały zaindeksowane.

W związku z tym – jak już wcześniej wspominałam – strony internetowe, które zawierają thin content czy też nie są odpowiednio zoptymalizowane pod wytyczne wyszukiwarki pod względem zarówno technicznym, jak i treści, nie są przez algorytmy brane pod uwagę i często występują na nich duże problemy z indeksacją.

Jak więc wyeliminować błędy techniczne i przyspieszyć indeksowanie stron? Konieczne będzie wdrożenie wszystkich informacji z listy kontrolnej zamieszczonej powyżej. Mogą nam w tym pomóc narzędzia SEO, a także wtyczki badające szybkość ładowania się strony. Warto skorzystać z profesjonalnej analizy technicznej oraz analizy contentu na stronie.

Problemy z renderowaniem JS – co zrobić? Czym jest server-side rendering?

Server-side rendering to technika stosowana w budowaniu stron internetowych, szczególnie tych opartych o JavaScript, dzięki której proces renderowania odbywa się po stronie serwera zamiast w przeglądarce (client-side rendering). Kiedy użytkownik próbuje otworzyć stronę, serwer już wcześniej przygotowuje kompletny widok i wysyła go do przeglądarki. Dzięki temu zamiast oczekiwać na pobranie kodu JavaScript, użytkownik od razu otrzymuje gotową stronę, co skraca czas jej ładowania. Zastosowanie tego rozwiązania jest bardzo ważne także dlatego, że boty najpierw odczytują kody HTML, CSS i linki, a renderowanie zawartości w JS zostawiają sobie na później, co może mieć negatywny wpływ na szybkość indeksowania strony, jak również na samą skuteczność pozycjonowania.

W odniesieniu do crawl budget rozbudowanych serwisów internetowych zaprojektowanych przy użyciu języka JavaScript server-side rendering jest opcją naprawdę skuteczną i przyjazną SEO. Co prawda stanowi większe obciążenie dla serwerów, ale zapewnia stałe indeksowanie stron przez roboty Google i lepsze doświadczenia użytkowników.