Co składa się na user agent string?

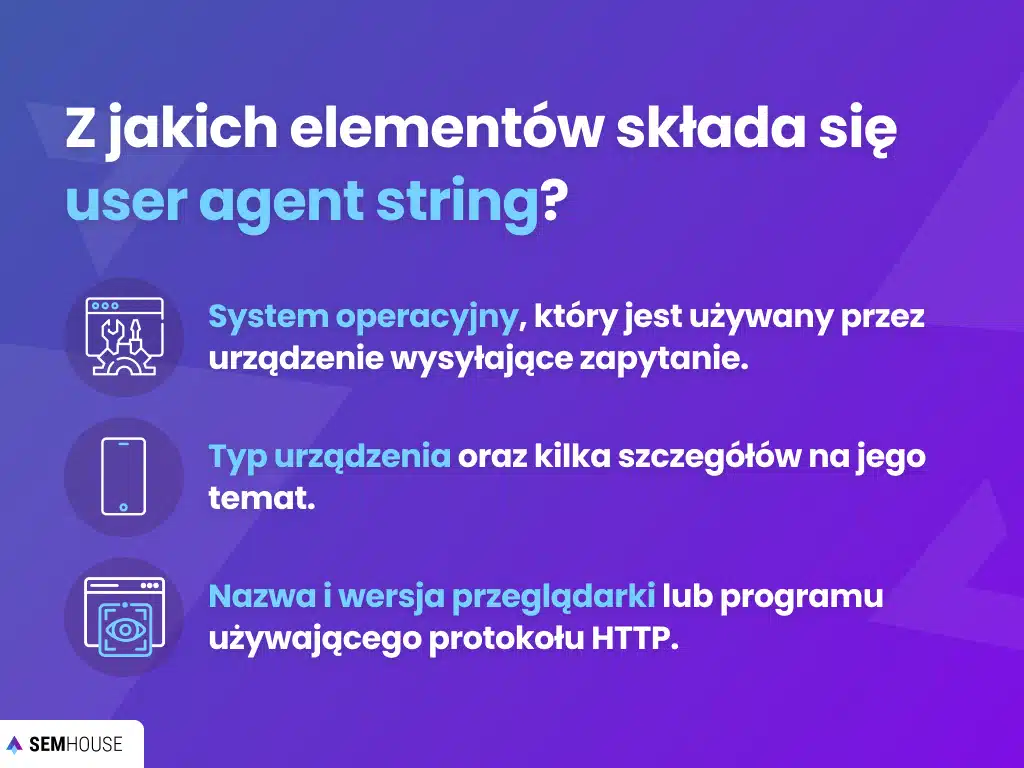

User agent string zawiera z reguły kilka podstawowych parametrów opisujących przeglądarkę oraz urządzenie. Przeglądając user agent string można odczytać:

- system operacyjny używany przez urządzenie wysyłające zapytanie;

- typ urządzenia i kilka szczegółów na jego temat;

- nazwę i wersję przeglądarki/programu używającego protokołu HTTP.

Warto jednak pamiętać o tym, że user agent nie zawsze musi zawierać informacje prawdziwe – mogą to być informacje umyślnie spreparowane w żądaniu HTTP. Informacje mogą być też dalekie od prawdy, gdy użytkownik korzysta z niestandardowej wersji przeglądarki.

Jak kontrolować dostęp user agent do Twojej strony za pomocą robots.txt

Mając dostęp do pliku robots.txt, w odpowiedniej linii definiujesz bota, którego mają dotyczyć instrukcje/dyrektywy (np. disallow, blokująca dostęp), które wydasz w liniach po tej linii następujących. Warto tutaj pamiętać o tym, że każda grupa user-agent/disallow powinna zostać oddzielona od siebie pustą linią, jednak w taki sposób, aby w grupie (w ramach jednej grupy) nie znajdowały się puste linie. Więcej na temat obsługi robots.txt przeczytasz w tym artykule.

Przykładowe komendy, które możesz wydawać user agent w pliku robots.txt

Wydając komendy w pliku robots.txt warto być ostrożnym, proste błędy mogą tutaj spowodować daleko idące konsekwencje. Jeśli masz jednak pewność tego co robisz, to poniżej przedstawiam podstawowe komendy:

| Komenda/dyrektywa: | Działanie komendy: |

| Disallow | Za pomocą tej komendy możesz wskazać strony które nie powinny być skanowane przez boty (nie ma limitu ilości disallow w robots.txt). |

| Allow (wspierana przez Google) | Działa w sposób przeciwny do Disallow. Używana, gdy na przykład blokujesz cały katalog za pomocą disallow poza jakimś podkatalogiem. |

| Crawl Delay (wspierana przez Google, Bing) | Stosowana, gdy chcesz np. zredukować obciążenie serwera. |

| Sitemap | Wydając komendę Sitemap: lokalizacja_mapy ułatwiasz crawlowanie strony robotom indeksującym. |

User agent – najczęściej zadawane pytania

Jaki rodzaj user agent należy do najpopularniejszych?

Najczęściej natrafić można na user agent: przeglądarki sieciowe (Google chrome, Mozilla Firefox, Microsoft Edge).

Czym jest zautomatyzowany user agent?

Indeksowanie stron, ich monitoring itp. są domyślnie wykonywane przez zautomatyzowane boty/crawlery. Narzędzia takie jak Screaming Frog SEO spider pozwalają na wybór user agent w konfiguracji narzędzia.